2014

habrahabr.ru/post/228157/

2017

habrahabr.ru/post/334044/

Мое мнение о топике 2017 года.

hostsuki.pro/all/popalsya-topik-na-habre-pro-oblaka.html

НО давайте так же порассуждаем и про облака. Отбросим джинсу статьи в сторону.

Все знают, что я ярый скептик на тему облаков. Потому что они меня многократно подводили. Не одно сука облако не дало мне ни денежной экономии в долгосрочной перспективе, ни надежности. И

даже проебали мои картинки с блогов. Никогда этого не прощу и никогда больше не куплю в той компании — это storage испортила их репутацию на десяток лет. Может когда мне будет лет 35 так — может быть я снова попробую. Я получил только минусы от работы с облаками, нежели плюсы.

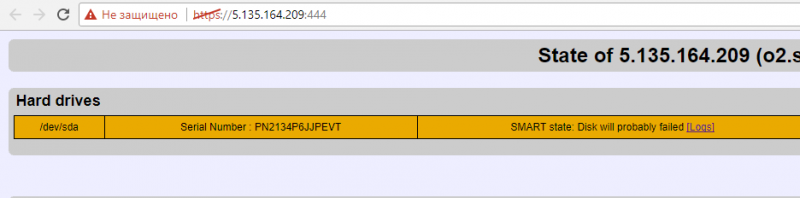

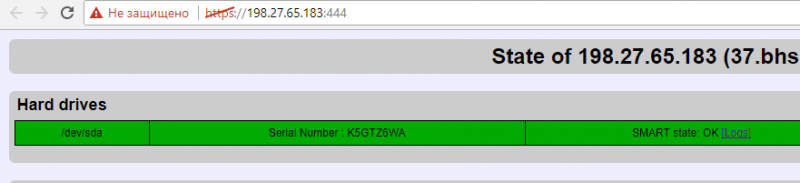

Сколько не работаю с дедиками — все просто работает. Ну разве что раз в 3 года там сменить дедик например придется, чтобы диски новые были или чтобы было еще дешевле. Ведь у дедиков не принято снижать цены на активные заказы, старые заказы по старым ценам, а новые могут быть в 2 раза дешевле. Тупо. Спрашивается почему же не снизить стоимость для старых заказов, которые тем более диски уже столетние и так далее. И не заставлять людей тратить время на переносы? Не знаю. Видимо дата-центры рассуждают по другому. Я в своем ДЦ буду каждый год снижать цены, вместе с устареванием железа. И потом — пока не сгорит, все по честному.

Ну ладно, возвращаемся к облакам. Или виртуальным услугам.

Целый год и 178 тысяч рублей мы потратили на умение работать

через панель VMmanager KVM.

И я сделал только один вывод — эта панель не пригодна для создания облака или реального бизнеса. Ну чтобы так, на поток поставить продажи и заниматься только продажами и расширением точек сайтов по миру. Чтобы было УДОБНО БЛЯТЬ ПРОДАВАТЬ и управлять услугами. Чтобы можно было просто взял, добавил мощностей, взял добавил сетей, взял добавил там тариф и пошел продавать по проектам. И я

осознал даже как должна выглядеть эта панель в будущем.

И в мире

я не нашел не одной другой — нормальной панели для создания облака.

Чтобы не было

этих узлов всяких. Чтобы не приходилось сохранять по таблицам на каком сервере какие сети IP и какие там конфиги, сколько ядер, какие процы, сколько озу и главное сколько там места, чтобы не продать больше чем есть.

Панель должна соединять все ноды, разные ноды, разные мощности — соединять все в одну большую мощность. Которую уже бы делили на тарифы и продавали. Вот что такое облако. И кстати

я хочу гейм-облако, потому что именно игры удобно делать на виртуалках, а не дедиках, т.к. это текучка и которой всегда может понадобиться расширение.

В моем понимании панель должна делать и слепки которые пилятся нормально в отдельные хранилища, а не пожирают места на ноде или лимите тарифа VDS. Которая должна уметь копировать виртуалки на горячем, прямо делать копию. Должно быть именно гибкое облако, чтобы я не упирался в ресурсы сервера. Чтобы можно было масштабировать. Из 8 озу сделать 80 сразу, а не выискивать потом где сколько озу свободно на каком узле и окажется что нигде, что проще купить челу дедик, потому что максимальный узел заканчивается на 64 озу и нод с 128 или 256 просто не делалось. Разве это облако? Это просто отдельные узлы! На панелях Vmmanager — нихуя не возможно масштабировать. Во первых нехватка места постоянная, нельзя все сервера собрать в кластер. Нельзя создать массив из 50 ТБ например. Нельзя соединить процессоры как-то в общую вычислительную мощность. У меня есть клиенты которые соединяют hetzner сотни серверов, но они все сами умеют и у них конечно же свои разработки. И конечно же панель должна уметь работать с крупными пулами айпишек, но увы когда ты покупаешь в аренду сервера с 16 штуками — невозможно заставить тот или иной IP работать на другом узле, его даже не передвинуть без потерь. А облако должно уметь. Так что короче — одни разочарования у меня от работы с VMmanager, это просто панель для частника поиграться в виртуальное. Или

создавать дешевые VDS по фану.

И вот, эта недавняя статья с Хабра сейчас поможет нам.

Что они там пишут ?

- VMware ESXi

- vCloud

- VMware vSphere 6U2

- RedHat KVM

- Microsoft Hyper-V

- Hyper-V Failover Clustering

- VMware vSphere 6.0

- VMware ESXI 5.5

- KVM OpenStack

- QEMU/KVM

- ESXi vCloud Director

Не одно облако кстати — не указало VMmanager панель.

Далее. Хранилища — то, что я хотел бы видеть в VMmanager. Но опять же, при методе аренды дедиков на стороне — это не выполнимо. Такое хранилище или облако можно сделать только в своем ДЦ.

- EMC VNX5600, HP 3Par 7400

- СХД SSD AllFlash, дублированные контроллеры. До 1 млн IOPS

- IBM mid-range уровня (4 штуки, 2 на каждый ЦОД) и all-flash массивы Violin Memory

- EMC VNX5600, HP 3par 7400

- Huawei OceanStor 5300

- Infortrend ESDS 3024B

- NetApp V6240, V8040 с использованием flash кэширования и SSD дисков

- EMC SCALEIO (с использованием нескольких СХД NettApp DS4246)

- HP 3PAR StoreServ 7400 и NetApp FAS3250

- NetAPP FAS8020

- СХД на базе решения Dell, Hitachi, Huawei

- HDS HUS VM/IBM Storwize v7000

- СХД на базе платформ Supermicro, логически Openstack Ceph

- NetApp FAS8040, FAS2552

- NetApp V6240, V8040 с использованием flash кэширования и SSD дисков

- EMC VNX, HP 3PAR

- NetApp V6240 и FAS8040

- VMware VSAN

- HP MSA 2040 SAN, Huawei OceanStore 2600T и, самая мощная: Huawei OceanStore 5500 V3, которая выдаёт до 320 000 IOPS

- HP 3PAR StoreServ 10400 IBM StorWize V7000 IBM XIV

Какие выводы можно сделать?

Пока никаких.

Но погуглив на все это — есть над чем подумать.

Поэтому этот топик тоже пригодится. Во всяком случае, чтобы потом не искать в закладках где-то. Хранить только на своих проектах Истории.