Карта сайта HostSuki.pro за 2017

История:

- Карта сайта HostSuki.pro за 2016

- Карта сайта HostSuki.pro за 2015

- Карта сайта HostSuki.pro за 2014

- Карта сайта HostSuki.pro за 2013

- Карта сайта HostSuki.pro за 2012

- Obzor.ly за 2017 год — отсутствует, т.к. Блог в архивной стадии, пока есть OVH, бегать и искать «надежную гавань» больше не требуется, поэтому и обзоров больше нет.

- Obzor.ly за 2016 год

- Obzor.ly за 2015 год

- Obzor.ly за 2014 год

- Obzor.ly за 2013 год

- Obzor.ly за 2012 год

2017 год

Январь- Флешка на 2 ТБ

- Kaby Lake выходят на рынок (BenchMark i7-7700k)

- Компания D-Wave открыла код вычислительного пакета для квантовых компьютеров

- Кто в складчину, нада кому ? (топик о ЮЛ анализе рынка)

- Закупщик для Яндекса

- Google патентует плавучие дата-центры

- Ответчиком телеканал выбрал провайдера хостинга 3NT Solutions LLP

- Google Infrastructure Security Design Overview

- Online распродажа (распродажа была мощь)

- 2,6 млрд. на аренду ЦОДов и 4000 стоек для «Почты России»

- CDN статика от mail.ru

- Caravan => reg.ru

- Битрикс-24 50% скидка

Февраль

- KuberDock closed

- Дайджест hosting.kitchen за Январь

- на ботов пришлось почти 52% интернет-трафика в 2016 году

- i7-7700K в РФ (практически никогда наличия не было, в итоге все равно ОВХ покупался)

- Когда порнуха пишет абузы

- Любые аниме проекты — бесплатно

- Коллективный хостинг

- Кстати напоминаю — 40%

- Антивирус от Cloudlinux

- Месяц прошел, отказы посчитали, снова winter-2017-sales (снова распродажа, закормили в этом году, что на черную пятницу потом не хватило, да и летом я уже видел как всем похуй было на серверы с распродажи, это было нечто, даже бесплатно были не нужны)

- Через два года Whois перейдет под контроль VeriSign

- Colo в OVH (а потом сделал Colo и Hetzner)

- Кстати, а кто что делает с серверами коло ? (пока что практического опыта так и не удалось создать)

- Баг чипа Atom С2XXX (за 2017 не сгорело ничего у меня, но ДЦ всегда были распроданы данные модели, вероятно перестали покупать)

- ForTeam отмучлся (для меня это такая же судьбоносная новость, как например смерть Агавы для рынка)

- А вам не кажется что все так ?

- AMD Ryzen 7 установил новый мировой рекорд

- А что бы было, если бы google/facebook и др

- i7-6700k в РФ №2 (на самом деле кроме новости толком ничего не было, не видел как-то наличия нормального даже, ни отзывов что кто-то там закупал именно эти процы, да и я сам пытался купить, всегда не доступен проц был в конфигураторе)

- Повышение цен на домены Ru и Рф с июля 2017 года

- vk.me — локнули за абузы картинок

Март

- Дайджест hosting.kitchen за Февраль

- chipcore.com — новый сайт Технодома

- Только спустя 9 месяцев пользования VMmanager (начало страданий этого года — получаем новый опыт)

- cloud hosting provider comparison 2017

- benchmark.stream (за 2017 насобирали разных процессоров)

- Global Anti-DDoS > 2Tbps

- Facebook объявляет о сквозном обновлении парка

- newGTLD — с 20 до 300

- ISPsystem обновили сайт

- Говорят веб-студии хотят открыть хостинги ?)

- OVH Singapour

- А РФ все так же продолжает терять клиентов

- Вебинар от selectel

- Бегет стал аккредитованным регистратором доменов

- Кстати, время продлений nic.ru

- Года 4 назад был такой комментарий

- вторая встреча AWS User Group

- Intel NUC в Google Cloud ?

- Alibaba Cloud

- Google хочет локнуть 30 тыщ SSL symantec

- WebMoney сразу ссылка на оплату

- Один все таки минус есть

- Очередной CodeFest

- BILLmanager 6

- Обновилась линейка Game OVH

- reg.ru и бесплатные ssl 2

- ihc.ru — обновил VDS

- IX тред

- DCImanager в ЦОДы.рф

- семейство процессоров Intel Xeon E3-1200 v6

Апрель

- 2000 серверов в день (если честно я так и не понял, работает ли этот процесс, как-то не верю что 2000 серверов в день производится в ОВХ, хотя продажи конечно там большие сотнями продается в сутки и скоро будет 1 миллион дедиков у них, щас ID приближается к 900 тысячам, в 2014 например шла первая 50к, у меня еще живой один такой легендарный сервер с таким номером)

- ISPmanager v5 lite за 1200р

- Дайджест hosting.kitchen за Март

- Недооцененные фишки Billmanager (вот таких например полезный статей — ХУЙ я больше напишу про v6)

- Мы показываем, куда мы хотим двигаться © (или таких, мне вообще похуй что там будет происходить с v6, обязательно порекомендую любой аналог клиенту, а не цензорную панель неуважающую интернет людей и клиентов которые принесли за год 30к евро)

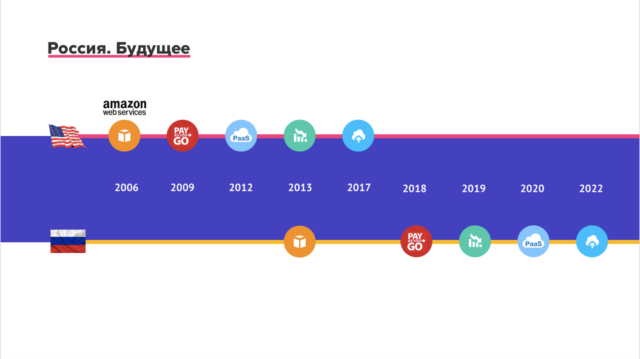

- OVH купила VMware vCloud Air (КСТАТИ вот новость про которую я забыл написать в итоговой пост НГ, а ведь это важная новость, особенно если вспомнить мои рассуждения про специалистов, про панели на рынке. как я лично вижу рынок ПО в полном кризисе, и панели продаются тем, кто на них больше всего пилит услуг; поэтому наверно лучшая панель будет — когда какая-ниб крутая компания, типо яндекса, мейла, селектела — сделает свою и на ее базе весь рынок начнет пилить, а она контролировать это и иметь доступ до базы, если все на базе их панели, куда просто добавляются узлы со всех ДЦ мира, для всех компаний, ну как я писал; это уже будет не просто панель, а именно облако по стране, а то и по миру, чем может кончиться такая идея никто не знает, но я вижу потенциал.)

- Петабайт в чемодане

- Rightside oпубликовал топ продаж

- Uniregistry существенно смягчила меры

- Телефония от Яндекса

- Qrator Radar

- Протестировали Xeon-E3-v6

- Про модель «сервиса и услуг» (еще одна статья, которые я достаточно редко публикую)

- О сервисах для разработчиков (продолжение моих мыслей)

- AMD Ryzen в Hetzner

- VPS OVH перевалили за 400000 ID (на конец 2017 почти к 500к VPS ID подходим, такими темпами через года 3 они догонят по кол-ву дедики)

- Пользуясь продуктами ISP — будь готов отвечать одно и тоже, одно и тоже, одно и тоже (кстати многие баги так и не исправлены, но я больше не слова этим пидорасам не напишу, а вот клиенту буду вот так вот постоянно отвечать, типо говно панель же, и давать еще ссылку на цензор)

- Нужен еще один контентный проект

- Технодом обновил тарифы (за 2017 год единственное в РФ по приемлемым ценам оказалось, и кстати можно сделать еще дешевле даже, но продавать сыкотно из-за ддос атак, а так я бы и без предложенных мне скидок напродавал)

- Intel Optane Disks

- в таблицы маршрутизации Ростелекома 50 префиксов

- Доход Microsoft от Azure увеличился на 93%

Май

- Дайджест hosting.kitchen за Апрель

- Думаю можно апнуть топик (Тема до сих пор актуальна)

- Google прекратил наращивать вес HTTPS как фактора ранжирования

- ICANN62 состоится в Панаме 25-28 июня 2018 года

- VMmanager в будущем будет ставится только на CentOS (ага, который сам по себе еще сдыхает при обновлениях, т.к. на v6 переходить я точно не буду, думаю просто отключу все обновы к тому времени и пусть работают «пока сами серверы не сгорят», а восстановлю уже сгоревшее или переселю людей надеюсь через 2-3 года в какую-ниб панель от нашей страны, в какое-ниб облако от какого-ниб дата-центра, где есть свои программисты и который сделает собственную панель для резалки VPS-ок из любого дц мира, но с ядром на базе его дата-центра и сотрудников)

- Норвегия

- Виртуальное против Физическое

- На AWS заработали IMAP и SMTP

- Early access to our new servers

- Ботоводы экономщики

- мы начинаем обнаруживать хосты с уязвимыми портами в вашей сети

- Ethereum создал свою доменную зону

- 10 000 активных VDS на ihor.ru

- Как выглядит водянка (вот мне было интересно что-то новое открыть для себя)

- Новые треш VDS-ки (15 долей на 1 ноду)

- Платный рассказ о Virtuozzo

- Запилил последовательность стройки новых ДЦ OVH (нада будет в новом году так же обновить, сейчас сделал еще лучше, и даже сделал то, что должны были делать сами ОВХ, но почему-то за интернет модой они не следят и купили говно домены, говно одежду, а ведь хотели удивить рынок США — вот и купили бы новые домены, чтобы удивить, похоже кто продвигает америку в овх — просто не шарит в интернете)

Июнь

- Skylake in Google Cloud (тоже интересная новость достаточно была)

- Amazon Lightsail — Tokyo, Mumbai, Singapore, Sydney (ну и эти VPS-ки из 2016 года, если честно про них как-то мало что слышал, но вероятно свое дело они делают и чистят рынок, где-то в других странах, не у нас, у нас ОВХ только)

- GPU instances (вот такое будет в 2018 все больше и больше, я писал в НГ)

- Firstvds написали интересную статью — 1 SSD и 2 SATA HDD по 4ТБ в зеркале (в НГ писал как раз про подобные статьи когда говорил о фестах)

- Как хорошое FAQ увеличивает продажи (что уж говорить о уважении, если у них сотрудники даже ленились FAQ написать целых 3 года никто не мог запустить их панель, а как только запустили так сразу сколько народу накупило и сколько хостингов с VPS-ovh появилось)

- Дайджест hosting.kitchen за Май

- Помните Proxmox, была такая панель

- Digitalocean firewalls

- сам ovh создает реселлеров © (проблема и по сей день, например с ноябре когда они тарифы меняли, баги с отключением серверов, снова серверы не отключаются, мы с вовой написали им десяток тикетов в разные места, как думаете, нам хоть один сотрудник на зар плате поверил? нет конечно же. истина в том, что мы знаем о ОВХ больше чем их сотрудники, такие вот пироги :)) я думаю без моих публикаций активного клиента — хуй бы ОВХ вообще что-то продало в СНГ и РФ)

- Блокчейн + распределённое хранилище

- amazon закрывает безлимитное хранилище

- Сравнение моделей SSD от servers.com

- En+ Иркутск cloud38.ru (блять, там контейнер оказался, а я думал в новостях полноценный ДЦ, это фиаско просто — вот так у нас в стране новости продвигаются не честные)

- Наглядный пример OVH antiddos (как только любая РФ компания сделает такое и гордо объявит что теперь не будет у них заблокирован не один заказ — она сразу почувствует как все начнут там покупать у нее)

- Alibaba Group Holding сообщила о строительстве новых дата-центров (как-то особых новостей не было на эту тему, в 2018 мне интересно посмотреть и на их панель и куда они движутся)

- VestaCP в шаблонах OVH

- наконец-то официальные маркировки ДЦ OVH (по идее они должны были сделать это все на их доменной зоне .ovh — заранее промаркировать брендинг, а потом уже начинать публиковать фотки ДЦ, но опять тысячи сотрудников, никто не подумал у них)

- Большая тройка начинает толкать ?

- Полный список доменов в зоне ru/su/tatar/рф/дети

- Хочу увидеть собственными глазами © (статистика пишется, но пока что ничего массового не сгорает, обидно, я бы реально хотел каждую неделю сгор, это было бы весело)

- Фичи VMmanager KVM (одна из итоговых топиков, опыта с цензорной панелью ISPsystem, на которые мы тратили деньги как раз в 2017 чтобы получить нового опыта, далее будет в разделе, а про v6 панели я вообще не напишу не одной новости, т.к. компания не понимает что такое интернет комментарии и не умеет уважительно даже вести себя в интернете, такой компании как они никогда в жизни сообщество в интернете не создать, потому что они просто тупо не шарят))

- FastVPS придумали локацию по быстрому для РФ

- Толкаю Идею (за этим явно будущее виртуалок в бюджетном сегменте и кто первый это сделает, тот захватит рынок бюдежетных хостеров, а по мне любое виртуальне это и есть бюджетное до 1000р, только частные облака мегафонов или газпромов не в счет)

- Hetzner обновил сайт (и придумали колокейшн)

- Отличная статья попалась про суперэкономщиков (вот такие люди и ходят на виртуалки как раз)

- Я часто слышал легенды о Stack.net — xelent.cloud

- Online.net — 2017 Summer Sale

- 100 Million Certificates Issued

- У Индии будет 16 доменных зон

- OVH привлекла еще €400 Million to Support its Strategic

- Дайджест hosting.kitchen за Июнь

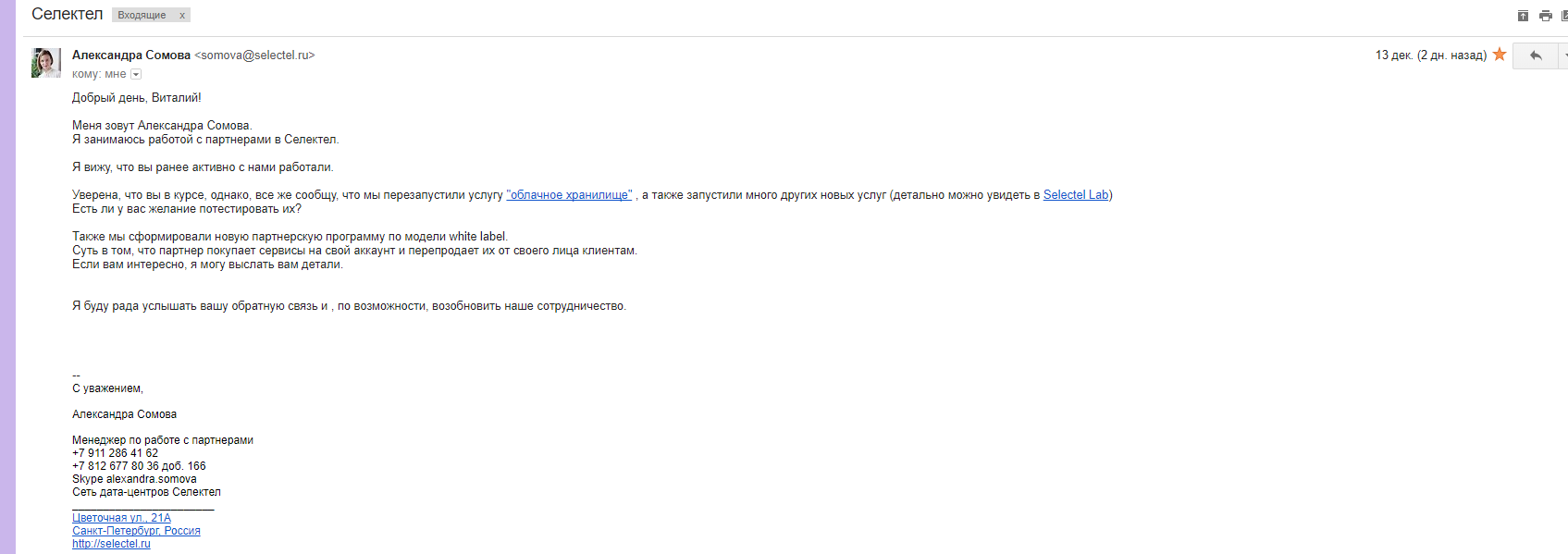

- В selectel все таки стали делать все правильно (пожалуй по итогу получился один из лучших сайтов в РФ)

- withdraw.web.money

Июль

- Бенчи AMD Ryzen

- ICANN: 750 регистраторов закроются в следующем году

- Wildcard Certificates от Lets в 2018

- 1 API and 1 Panel Control (сейчас очень удобно клиентам выдавать ОВХ аккунты, вот жду не дождусь когда и KS и SYS станут в той же панели — чтобы можно было выдавать доступы на управление каждому, а не только оптовым или доверенным)

- Статистика цены HDD

- А где эти корпоративные домены? )

- radar qrator выпустил очередную статистику

- Ох, Gold процессор )

- Google новый цод в Лондоне

- Intel Xeon Scalable

- А кто есть среди читателей ? (топик все еще активен)

- Online ДЦ — мысли итоги и планы (один из крутых топиков за 2017)

- Cloud DC Moscow 1

- Coffee Lake Core i7-8700K

- Роскомнадзор и Rusonyx

- Очередной познавательный пост от FirstVDS

- Selectel и Fortinet FG-100D

- Зоны .RU и.РФ получат усиленную защиту

- Появились характеристики Core i9

- BTC-e — sinaro.host

- 275 000 сайтов за пять лет

- В зоне .BLOG — 100 000 доменов

- попался топик на хабре про облака (отличный пример, почему Хабр больше не модный и не крутой; да и заметьте они даже опросы сейчас проводят такие, будто человек который составлял опрос кроме хабра ничего другого не читает, будто человек что составлял опрос не пользуется ни rss, ни почтой и тд — или например Тостер был хорошой площадкой 3-4 года назад, но Хабр набрал офисных сотрудников, которые просто перебанили всю аудиторию, потому что сотрудники сами похоже никогда в интернете на форумах не сидели и не понимают правил интернет общения, точно так же как цензорная ISPsystem — поэтому и деградация, люди далекие от интернета начинают работать в Интернет проектах)

- Продолжая топик про РФ облака

- зона .us будет стандарт тех-доменов

- Этим летом кажется все отдыхают, но не firstvds.ru

Август

- Дайджест hosting.kitchen за Июль

- Hetzner весь август нет платы за установку (интересно сколько было продаж, я думаю дофига, народу наверняка много обновилось в этом году, грех не обновиться было, такие раздачи это потом жалеть пару лет что не сэкономил)

- Перезапуск зоны .STORAGE (мне кстати так и не регнули)

- Ребята, а вы не почувствовали как дунуло ?

- В OVH даже диски метятся автоматом (тоже отличная крутая фича)

- game soyoustart windows

- Introducing Network Service Tiers: Your cloud network, your way

- Как меняют детали в OVH (продолжение той крутой фичи)

- nic.ru снова всех кинул

- Кстати давно хотел написать

- МакХост Евробайт и прочее

- soon 25/100G-Base

- Как меняют детали в Hetzner (тут вроде как есть поддержка, но на самом деле мне больше нравится метод ОВХ, когда просто покупаешь новый не продляешь, моментальная выдача, в hetzner же из-за их убогого метода оплаты — слишком геморно покупать и переезжать постоянно; кстати когда меня услышит hetzner и сделает хотя бы внутренний баланс себе — вот тогда у него понесутся отличные продажи, помяните мое слово)

- WMH — webmoney как биржа сделала дублирование

- selectel techday 2

- Intel Scalable в РФ

- Дайджест hosting.kitchen за Август

- Самые желаемые конфиги у французов (даже в европе есть экономшики, притом в РФ даже атомы эти никому не нужны, а в европе разбирают похоже)

Сентябрь

- New German GCP region – open now

- Не разу не писал, как мои блоги из года в год меняют рынок (кому-то потом знатно припекло, весь сентябрь раковал и пытался меня оскорбить или задеть, ничтожный аноним какой-то, не имеющий собственных проектов; но я лишь еще больше укрепился в том, что моя война правильна, чем больше троллей, тем сильнее я становлюсь и тем больше денег у них отбираю)

- пятерка лидеров РФ

- В Сентябре новостей почти нет

- Появились серверы по 1000р в РФ

- Amazon стал выставлять счета в секундах

- ISPsystem запустили новый багтрекер с цензурой

- МТС запустила облачный bigdata

- Почему новый багтрекер ISP только на зарубежном домене?

- Есть 300 тысяч на разработку (Тинькофф например 150 тысяч дарит за супер какие-то там задания, а я 300 — и что, не одного желающего? деньги похоже не нужны людям)

- Google Cloud в Бразилии

- Технодом, VK, десктопы (тоже она из лучших статей 2017)

- Voxility ввел скидки на оплату наперед

- Microsoft делает свою веб панель для Hyper-V

- FastVPS акция на РФ локацию

- Plati.ru переезжает на Plati.market

- Selectel запустила тест-лаб как OVH в свое время

- 7700k появился в DE и UK

- 7 лет Cloudflare

- Cloudflare Streams

- v1 v2 v3 v5 v6 ?

- MariaDB привлёчет $27 млн от Alibaba и группы инвесторов

Октябрь

- opennet.ru в ihor.ru (она из правильных методов рекламы)

- Дайджест hosting.kitchen за Сентябрь

- 10 лет roem.ru

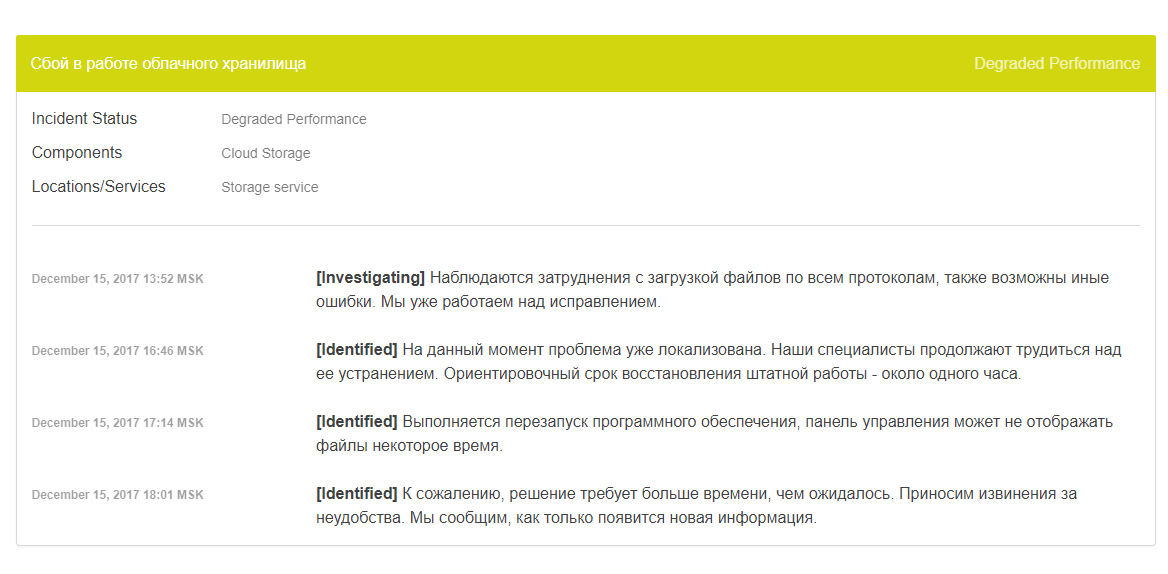

- Hetzner новая панель, OVH поднимает цены, Selectel хранилище из людских компов

- «Сбербанк» запустил страхование бизнеса от простоя из-за DDoS-атак

- Сколько раз вы запрашивали гарантии в интернете ? (многие путают интернет клиентов и клиентов по контракту, прямо вообще путают и разводят демагогии, я никогда ничего в жизни не запрашивал, честно, если меня кидают я просто запоминаю это и больше не покупаю)

- реестр всё же будет заполнен через несколько лет

- выгрузить e-mail контакты (как метод рекламы ?)

- Если вам нечего сказать людям, вам не нужен редактор (и это правда!)

- Кто в РФ сможет предложить такое же ?

- 1231v3 добавили на SYS

- Домен Казахстана предлагают изменить на .QZ

- А давайте-ка расскажите свою Историю Успеха

- попеременно уходили в отпуск или уезжали в командировки

- OVH делает новый Qrator (конечно же, будем ждать и надеяться что следующий год принесет новые интересные новости, 2017 был так себе по фону рынка, конфиги продавались теже самые, новинок не было)

- Я уж как-то и позабыл про донаты (подарить мне деньги, можно тут)

- Искали тут с другом стойку в МСК (и короче — не нашли, друг решил вложить миллион в КС-дропы и игровые рулетки всякие которые он и раньше делал, тоже прибыльные проекты к слову сказать, модель до сих пор живет и процветает, а я просто продолжил продавать ОВХ как и раньше, и делать треш-VPS на базе ОВХ)

- Единственное что можно почитать про цоды, ведь так ?

- Как должен выглядеть идеальный дата-центр ? (еще одна полезнейшая статья — пока ваш дата-центр не будет таким, его будет достаточно трудно продавать)

- OVH US сделали новый сайт (сделали и опозорились как по мне, это пиздец инновационная компания тут же стала выглядеть столетней Yahoo которая даже не шарил в интернет современной моде)

- Amazon Lightsail — Windows Virtual Private Servers

- А я как раз хочу продавать — все ДЦ мира :)

- i9x уже в продаже

- Let's Encrypt представил модуль для http-сервера Apache

- brainycp.com — новая бесплатная панель для сервера

- Hetzner.Cloud (похоже проект провалился)

- Интервью с servers.com (один из лучших топиков за год, и лучшее интервью)

- Виртуалки от mail.ru

- Hard Drive Stats for Q3 2017

- VeriSign и Afilias тестируют замену Whois

- Еще хороший пример как работают сотрудники в офисах

- Что думают о моих честных VPS (и это отлично, не жалко убытка даже ради таких слов)

Ноябрь

- Google Cloud Platform — India

- Дайджест hosting.kitchen за Октябрь

- Пример почему в РФ не популярны дедики

- ARM Qualcomm vs Intel CPU comparison

- SBG ovh — весь прилег (тоже важное событие этого года, но репутационых потерь не принесло, зато отодвинуло планы я уверен на год)

- SBG1 SBG4 — будут мигрированы в SBG3

- Что нового в мире ? (2018 год, надеюсь на тебя — ты покажешь мне нечто новое, жду :))

- Что такое самообслуживание ? (еще одна полезнейшая статья, я клиент, который с годами прокачался из нуба в нормального и больше вопросов в поддержку не задает, возвратов не требует и бесплатно рекламирует то, чем сам пользуется! таким должен становиться любой Интернетчик и создатель проектов в Интернете, иначе какой смысл создавать)

- Как получить компенсацию SLA OVH

- AMD EPYC 7401P 24-Core

- ISPsystem снова цензурит даже дискусс комменты (это был пик пиздеца, эти ублюдки просто так взяли и почистили ЧУЖИЕ слова, т.е. это тоже самое как взять и отредактировать чужую статью или чужой текст, чужой мозг, чужие мысли. сука это не уважать собеседника, это не уважать человека, не уважать сам Интернет и форумы даже. горите в аду ублюдки, не помогу вам больше вообще ничем и не напишу не одной новости и буду всем рассказывать по пути, какие вы на самом деле)

- Пошли компенсации SBG

- Cloud.Net — Закрывается

- число инвестиций в российские проекты

- Неужели никто из клиентов ОВХ не замечает лагов, кроме нас ?

- 4,99 евро до 2,79 евро

- Витрина РФ хостинга для ИП/ЮЛ

- .blackfriday

- Дайджест hosting.kitchen за Ноябрь

- LeaseWeb открывает 2 новых точки — UK и AU

Декабрь

- letsencrypt победил ?

- Vultr дедики и часовая оплата (в комментариях яркий пример офисного сотрудника, который не уважает деньги компании)

- Внезапно до меня дошло — как Хабр продвигает рекламу и стыдится за нее (хабр уже никогда не будет хабром, только если с нуля создастся)

- OVH тоже пробует Райзены

- Zare собирается в GPU

- Pavel Odintsov сделал сайт для своего антиддоса

- Disqus продан за $90 млн

- Бразилия лишилась собственных регистраторов

- Комиссия по связи США отказалась защищать «сетевой нейтралитет» в стране

- xakep.ru ищет авторов

- Как издевательство какое-то

- Две 0-Day vBulletin уязвимости

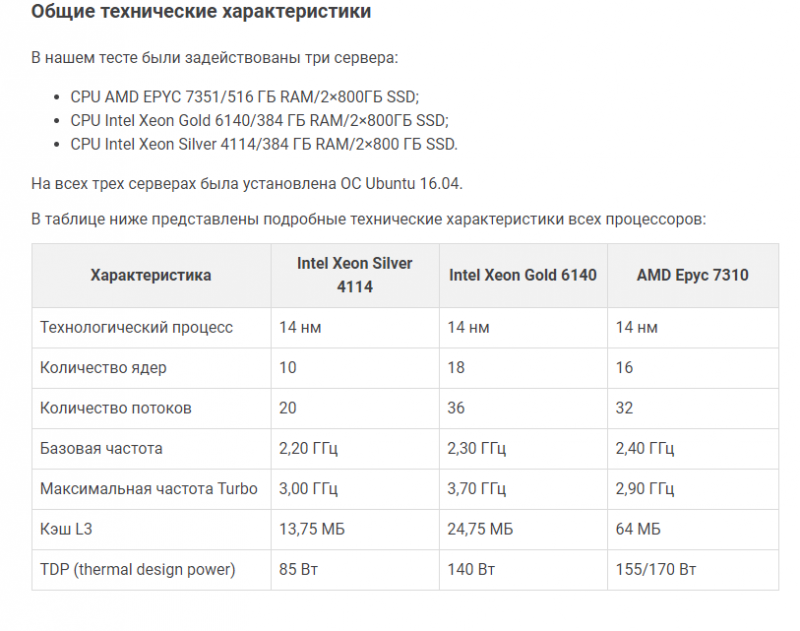

- Intel vs AMD: сравнительные тесты

- Mail.Ru Group Илья Летунов рассказывает

- 2017 год в хостинге (итоговый пост за год от меня)

- WML, обеспечивающий учет Litecoin

- Mail.Ru Cloud Solutions (MCS) (мысли наши совпали прямо, если честно люблю такие посты, когда оказывается что ты был прав)

- Дайджест hosting.kitchen за Декабрь